Amazon SageMaker Canvas

Präzise Machine-Learning-Prognosen generieren – kein Code erforderlichWas ist SageMaker Canvas?

Amazon SageMaker Canvas ist eine visuelle Schnittstelle ohne Code, mit der Sie Daten vorbereiten, hochpräzise ML-Modelle erstellen und bereitstellen und so den gesamten ML-Lebenszyklus in einer einheitlichen Umgebung optimieren können. Mithilfe von SageMaker Data Wrangler können Sie Daten im Petabyte-Bereich durch Point-and-Click-Interaktionen und natürliche Sprache vorbereiten und transformieren. Sie können die Leistungsfähigkeit von AutoML nutzen und automatisch benutzerdefinierte ML-Modelle für Regression, Klassifizierung, Zeitreihenprognose, Verarbeitung natürlicher Sprache und Computer Vision erstellen, die von SageMaker Autopilot unterstützt werden. Darüber hinaus können Sie mit wenigen Klicks auf Basismodelle von Amazon Bedrock und SageMaker JumpStart zugreifen, diese auswerten, optimieren und bereitstellen. Canvas fördert die teamübergreifende Zusammenarbeit, bietet Transparenz hinsichtlich des generierten Codes und gewährleistet Governance durch die Versionsverwaltung von Modellen und Zugriffskontrollen. Mit Canvas können Sie Innovationen beschleunigen und die Produktivität steigern. Entwickeln Sie schnell benutzerdefinierte ML-Modelle oder passen Sie Basismodelle an die Anforderungen Ihres Unternehmens an, unabhängig von Ihren Programmierkenntnissen.

Vorteile von SageMaker Canvas

Über den gesamten ML-Lebenszyklus entwickeln

Nutzen Sie die Funktionen für Machine Learning, einschließlich der Datenvorbereitung mit SageMaker Data Wrangler und des AutoML-Modelltrainings mit SageMaker Autopilot, über eine visuelle, codefreie Schnittstelle. Sie können Amazon Q Developer auch verwenden, um generative KI-gestützte Unterstützung beim Erstellen von ML-Modellen zu erhalten. Geben Sie einfach Ihr Ziel in natürlicher Sprache an, und Q Developer wird es aufschlüsseln und in eine Reihe von ML-Aufgaben übersetzen. Q Developer führt Sie dann durch die Definition des ML-Problemtyps, die Vorbereitung der Daten und die Erstellung, Bewertung und Bereitstellung Ihres Modells.

Bereiten Sie Ihre Daten visuell im Petabyte-Maßstab vor

- Zugriff und Import von Daten aus über 50 Quellen, einschließlich Amazon S3, Athena, Redshift, Snowflake und Databricks

- Datenqualität und Modellleistung mit über 300 vorgefertigten Analysen und Transformationen verbessern

- Visuelles Entwickeln und Verfeinern Ihrer Daten-Pipelines mit einer intuitiven Benutzeroberfläche, die ohne Codierung auskommt

- Daten mit wenigen Klicks auf Petabyte-Größe skalieren

Modelle für mehrere Problemtypen trainieren und auswerten

- Nutzung der Leistungsfähigkeit von AutoML zur automatischen Erkundung und Optimierung von Modellen für Ihren spezifischen Anwendungsfall

- Modelltraining für Regression, Klassifizierung, Zeitreihenvorhersage, Verarbeitung natürlicher Sprache, Computer Vision und Feinabstimmung von Basismodellen mit nur wenigen Klicks

- Maßgeschneidertes Modelltraining mit flexiblen Optionen für objektive Metriken, Datenaufteilungen und Modellkontrollen wie Algorithmusauswahl und Hyperparameter

- Einblicke in die Modellleistung mit interaktiven Visualisierungen und Modellerklärungen

- Auswahl des leistungsstärksten Modells aus einer Modell-Rangliste und Export des generierten Codes für weitere Anpassungen

Chat-geführte ML-Entwicklung mit Amazon Q Developer

- Beschreiben Sie Ihr Geschäftsproblem in natürlicher Sprache und lassen Sie sich von Amazon Q Developer über eine Chat-Schnittstelle durch den gesamten ML-Prozess zu einer Lösung führen

- Q Developer unterteilt Probleme in umsetzbare ML-Aufgaben und unterstützt Sie bei der Datenvorbereitung, Modellbildung, Auswertung und Bereitstellung

- Stellen Sie Fragen und erhalten Sie Antworten zu ML-Begriffen und Ihren Daten und Modellen

- Q Developer wendet fortschrittliche Techniken zur Datenvorbereitung und Modellbildung an und ermöglicht Ihnen gleichzeitig die vollständige Kontrolle über die Ausführung von Aufgaben

Präzise Vorhersagen im großen Maßstab generieren – im Batch oder in Echtzeit

- Interaktive Prognosen und Was-wäre-wenn-Analysen direkt in der Anwendung durchführen

- Bereitstellen von Modellen mit einem einzigen Klick an einem SageMaker-Endpunkt für Echtzeit-Inferenz oder Ausführen von Batch-Vorhersagen ad-hoc oder mit automatischen Zeitplänen

- Gewährleistung von Governance und Versionskontrolle durch Registrierung von Modellen in der SageMaker Model Registry

- Nahtlose Freigabe von Modellen mit Amazon SageMaker Studio für erweiterte Anpassungen und Zusammenarbeit

- Visualisierung und Freigabe von Prognosen mit Stakeholdern mithilfe von Amazon QuickSight für eine bessere Entscheidungsfindung

Zusammenarbeit und Gewährleistung von Governance

Demokratisieren Sie ML und fördern Sie gleichzeitig die Zusammenarbeit zwischen Teams. Ermöglichen Sie die Modellfreigabe und die Integration mit anderen AWS-Services für Governance und MLOps.

Förderung der teamübergreifenden Zusammenarbeit und des Wissensaustausches

- Zusammenarbeit mit Datenwissenschaftlern und Experten durch einfache Modellfreigabe mit SageMaker Studio

- Nutzung von Modellen, die von Datenwissenschaftlern im Canvas Workspace entwickelt wurden, um Vorhersagen zu generieren

- Mehr Vertrauen durch Codetransparenz mit automatisch generierten Notebooks

- Freigabe von Modellen, Vorhersagen und Einblicken für Interessengruppen über Amazon-QuickSight-Dashboards

- Versionskontrolle und Nachverfolgung der Modellherkunft, um die Reproduzierbarkeit und Rückverfolgbarkeit in verschiedenen Teams zu gewährleisten

Gewährleistung von Governance und bewährten Methoden für MLOps

- Implementierung differenzierter Berechtigungen und Zugriffskontrollen auf Benutzerebene für eine sichere Modellverwaltung

- Nahtlose Authentifizierung mit Single Sign-On (SSO)-Funktionen ermöglichen

- inhaltung von Modell-Governance und Versionsverwaltung durch Registrierung von Modellen in der SageMaker Model Registry

- Optimierung von MLOps-Pipelines durch den Export von Modell-Notebooks für weitere Anpassungen und Integration

- Kosten und Ressourcenauslastung mit Funktionen zum automatischen Herunterfahren optimieren

Mit Grundlagenmodellen bauen

- Einfaches Vergleichen und Auswählen des am besten geeigneten Basismodells für Ihre Aufgabe

- Optimieren der Basismodelle mithilfe Ihres gekennzeichneten Trainingsdatensatzes für geschäftliche Anwendungsfälle mit nur wenigen Klicks

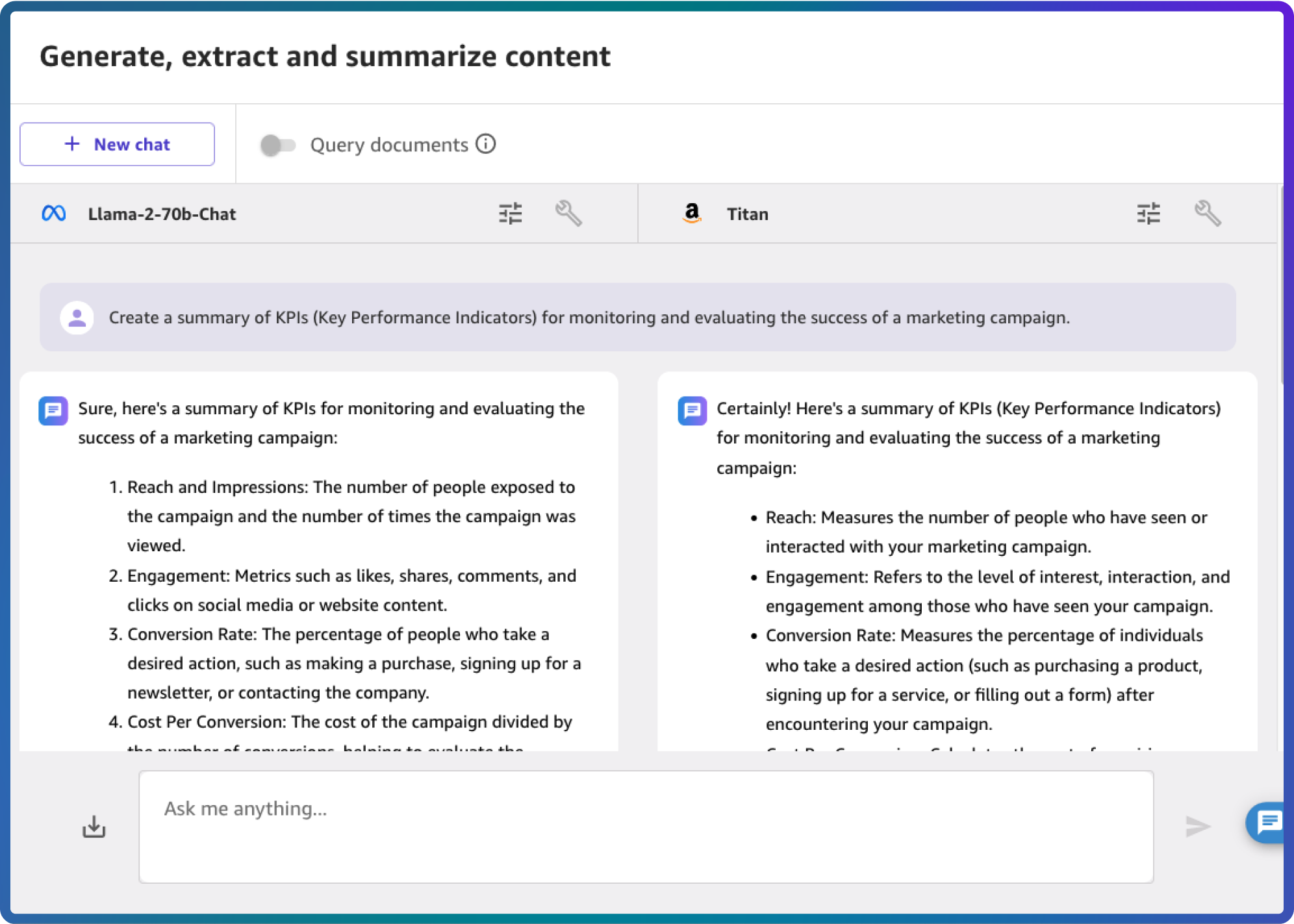

Anwendung von generativer KI

- Abfrage Ihrer eigenen Dokumente und Wissensdatenbanken, die in Amazon Kendra gespeichert sind, um maßgeschneiderte Ausgaben zu generieren

- Einblicke in die Modellleistung mit interaktiven Visualisierungen, Modellerklärungen und Ranglisten

- Produzieren und Bereitstellen der am besten geeigneten Basismodelle an SageMaker-Endpunkte in Echtzeit