Übersicht

QnaBot auf AWS ist eine generative künstliche Intelligenz (KI) -Lösung, die auf Kundenanfragen in mehreren Sprachen und Plattformen reagiert und Konversationen über Chat, Sprache, SMS und Amazon Alexa ermöglicht. Dieser vielseitige Assistent hilft Unternehmen dabei, den Kundenservice durch sofortige, konsistente Antworten über eine Vielzahl von Kommunikationskanälen zu verbessern, ohne dass eine Codierung erforderlich ist.

Vorteile

Bereitstellung von personalisierten Tutorials sowie Frage- und Antwort-Support mit intelligenter mehrteiliger Interaktion. Importieren und exportieren Sie ganz einfach Fragen aus Ihrer QnABot-Einrichtung.

Verwenden Sie die Funktionen der natürlichen Sprachverarbeitung (NLP) von Amazon Kendra, um die Fragen der Menschen besser zu verstehen. Erstellen Sie Konversationsanwendungen mit Amazon Bedrock, einem verwalteten Service, der leistungsstarke Basismodelle bietet.

Automatisieren Sie Kundensupport-Workflows. Erzielen Sie Kosteneinsparungen und bieten Sie Ihren Kunden einen besseren Service, damit sie genaue Antworten erhalten und schnell helfen können.

Nutzen Sie Absicht- und Slot-Abstimmung für verschiedene F&A-Workflows. Nutzen Sie natürliches Sprachverständnis, Kontextmanagement und mehrstufige Dialoge mithilfe von großen Sprachmodellen (LLMs) und Retrieval Augmented Generation (RAG).

Technische Details

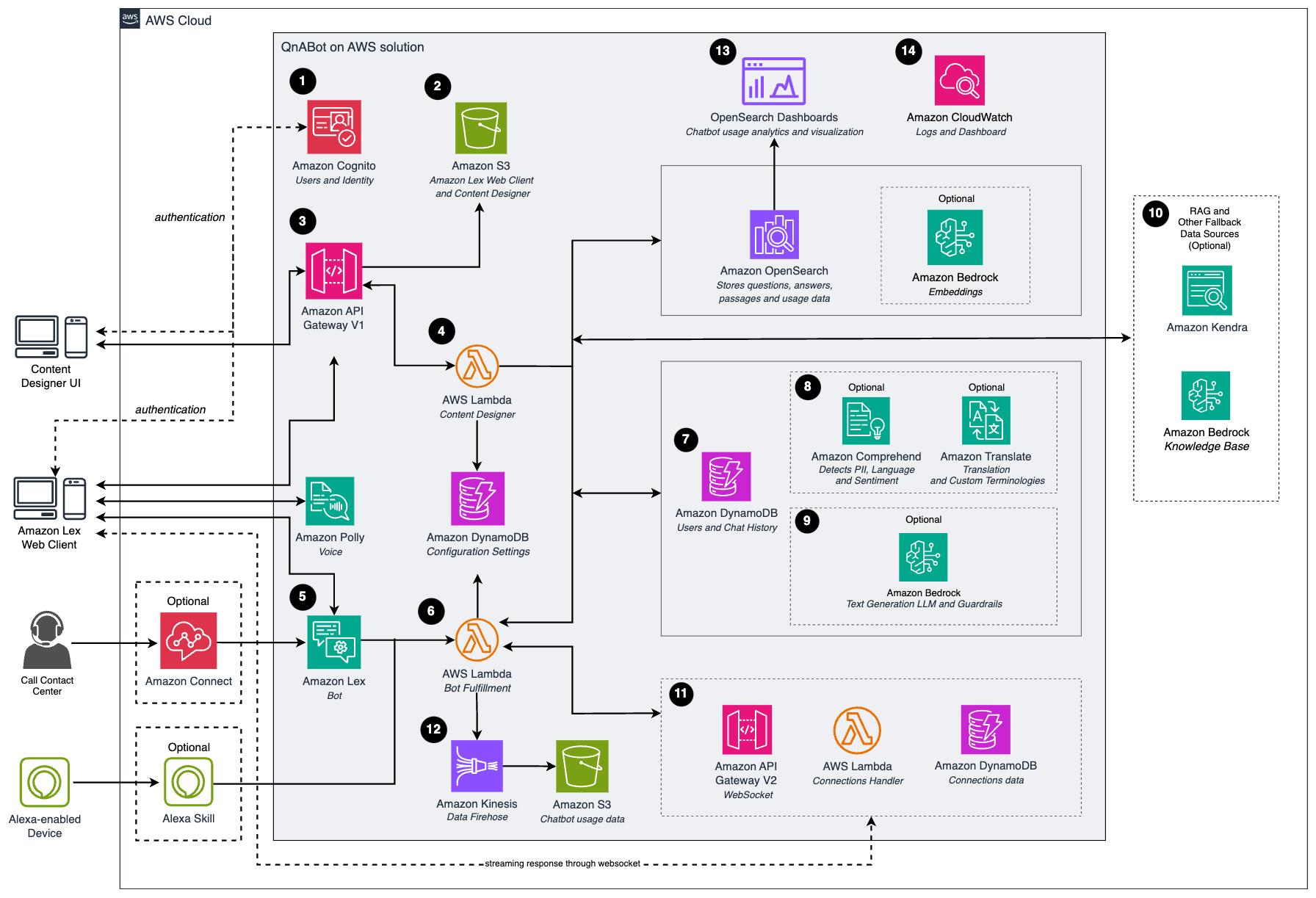

Sie können diese Architektur mit dem Implementierungsleitfaden und der geeigneten AWS-CloudFormation-Vorlage automatisch bereitstellen. Wenn Sie die Bereitstellung mit VPC durchführen möchten, stellen Sie zunächst eine VPC mit zwei privaten und zwei öffentlichen Subnetzen bereit, die über zwei Availability Zones verteilt sind, und verwenden Sie dann die QnABot-VPC-AWS-CloudFormation-Vorlage. Verwenden Sie andernfalls die QnABot-Main-AWS-CloudFormation-Vorlage.

Schritt 1

Der Administrator stellt die Lösung in seinem AWS-Konto bereit, öffnet die Content-Designer-Benutzeroberfläche (UI) oder den Amazon-Lex-Webclient und verwendet Amazon Cognito zur Authentifizierung.

Schritt 2

Nach der Authentifizierung liefern Amazon API Gateway und Amazon Simple Storage Service (Amazon S3) die Inhalte der Content-Designer-Benutzeroberfläche.

Schritt 3

Der Administrator konfiguriert Fragen und Antworten in Content Designer und die Benutzeroberfläche sendet Anfragen an API Gateway, um die Fragen und Antworten zu speichern.

Schritt 4

Die AWS-Lambda-Funktion von Content Designer speichert die Eingabe in Amazon OpenSearch Service in einem Fragenkatalogindex. Bei der Verwendung von Texteinbettungen durchlaufen diese Anfragen LLMs, die auf Amazon SageMaker oder Amazon Bedrock gehostet werden, um Einbettungen zu erzeugen, bevor sie in der Fragenbank auf dem OpenSearch Service gespeichert werden.

Darüber hinaus speichert der Inhaltsdesigner die Standard- und benutzerdefinierten Konfigurationseinstellungen in der Amazon Dynamo-Datenbank.

Schritt 5

Nutzer des Assistenten interagieren mit Amazon Lex über die Web-Client-Oberfläche, Amazon Alexa oder Amazon Connect.

Schritt 6

Amazon Lex leitet Anfragen an die Bot-Fulfillment-Lambda-Funktion weiter. Benutzer können auch Anfragen an diese Lambda-Funktion über Amazon Alexa-Geräte senden.

Hinweis: Wenn Streaming aktiviert ist, verwendet der Chat-Client den Amazon Lex Sitzungsbezeichner (sessionId), um WebSocket-Verbindungen über API Gateway V2 herzustellen.

Schritt 7

Die Benutzer- und Chat-Informationen werden in Amazon DynamoDB gespeichert, um Folgefragen aus dem vorherigen Frage- und Antwortkontext zu unterscheiden.

Schritt 8

Die Lambda-Funktion zur Bot-Erfüllung verwendet Amazon Comprehend und, falls erforderlich, Amazon Translate, um Anfragen in einer anderen Sprache als Muttersprache in die vom Benutzer bei der Bereitstellung gewählte Muttersprache zu übersetzen. Die Funktion fragt dann den OpenSearch-Dienst ab, um die entsprechende Antwort abzurufen.

Schritt 9

Wenn Sie LLM-Funktionen (Large Language Model) wie Textgenerierung und Texteinbettung verwenden, durchlaufen diese Anfragen zunächst verschiedene grundlegende Modelle, die auf Amazon Bedrock gehostet werden. Dadurch werden die Suchabfrage und die Einbettungen generiert, die dann mit denen verglichen werden, die in der Fragenbank des OpenSearch-Dienstes gespeichert sind.

Schritt 9A

Wenn Vorverarbeitungsleitern aktiviert sind, scannen und blockieren sie potenziell schädliche Benutzereingaben, bevor sie die QnaBot-Anwendung erreichen. Dies ist die erste Verteidigungslinie, um zu verhindern, dass böswillige oder unangemessene Anfragen verarbeitet werden.

Schritt 9B

Wenn Sie Amazon Bedrock Guardrails für LLMs oder Amazon Bedrock Knowledge Bases verwenden, können während der LLM-Inferenz kontextuelle Schutzmaßnahmen und Sicherheitskontrollen angewendet werden, um eine angemessene Antwortgenerierung sicherzustellen.

Schritt 9C

Wenn die Nachbearbeitungsleitplanken aktiviert sind, scannen, maskieren oder blockieren sie potenziell schädliche Inhalte in den endgültigen Antworten, bevor sie über das Fulfillment-Lambda an den Kunden gesendet werden. Dies ist die letzte Verteidigungslinie, um sicherzustellen, dass vertrauliche Informationen wie personenbezogene Daten (PII) ordnungsgemäß maskiert und unangemessene Inhalte blockiert werden.

Schritt 10

Wenn keine Übereinstimmung aus der OpenSearch Service Fragenbank oder Textpassagen zurückgegeben wird, leitet die Bot-Erfüllung Lambda-Funktion die Anfrage wie folgt weiter:

Schritt 10A

Wenn ein Amazon Kendra-Index für Fallback konfiguriert ist, leitet die Bot Fulfillment Lambda-Funktion die Anfrage an Amazon Kendra weiter, wenn von der OpenSearch Service-Fragenbank keine Übereinstimmung zurückgegeben wird. Das LLM zur Textgenerierung kann zur Erstellung der Suchanfrage und zur Synthese einer Antwort aus den Auszügen des zurückgegebenen Dokuments verwendet werden.

Schritt 10B

Wenn eine Amazon Bedrock Wissensdatenbank-ID konfiguriert ist, leitet die Bot-Erfüllung Lambda-Funktion die Anfrage an die Amazon Bedrock Wissensdatenbank weiter. Die Funktion Bot Fulfillment Lambda verwendet dann die APIs RetrieveAndGenerate oder RetrieveAndGenerateStream, um die relevanten Ergebnisse für die Abfrage des Benutzers abzurufen, die Eingabeaufforderung des Basismodells zu ergänzen und die Antwort zurückzugeben.

Schritt 11

Wenn Streaming aktiviert ist, werden die LLM-Antworten aus Textpassagen oder externen Datenquellen durch Retrieval-Augmented Generation (RAG) verbessert. Antworten werden über WebSocket-Verbindungen mit derselben Amazon Lex-SessionId gestreamt, während die endgültige Antwort über die Fulfillment-Lambda-Funktion verarbeitet wird.

Schritt 12

Benutzerinteraktionen mit der Bot-Fulfillment-Funktion werden protokolliert, und die resultierenden Metrikdaten werden an Amazon Data Firehose gesendet und dann zur späteren Datenanalyse an Amazon S3 weitergeleitet.

Schritt 13

Die OpenSearch-Dashboards können verwendet werden, um den Nutzungsverlauf, protokollierte Äußerungen, Äußerungen ohne Treffer, positives Benutzerfeedback und negatives Benutzerfeedback anzuzeigen und bieten auch die Möglichkeit, benutzerdefinierte Berichte zu erstellen.

Schritt 14

Mithilfe von Amazon CloudWatch können die Administratoren Serviceprotokolle überwachen und das von QnaBot erstellte CloudWatch-Dashboard verwenden, um den Betriebszustand der Bereitstellung zu überwachen.

- Datum der Veröffentlichung