-

ソフトウェア

-

サービス

-

サポート

-

Insights

-

比較

-

詳細

-

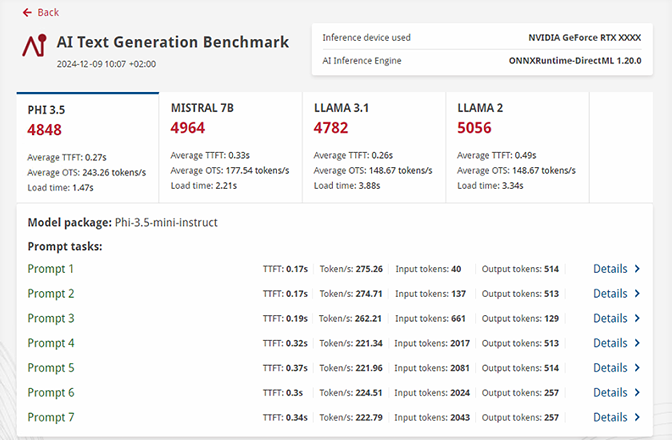

AI LLMのパフォーマンステストは非常に複雑で時間がかかります。フルサイズのAIモデルでは、ダウンロードに大量のストレージスペースと帯域幅が必要になります。量子化、変換、および入力トークンのバリエーションなどの多くの変数があり、適切に設定されていないと、テストの信頼性が低下する可能性もあります。

Procyon AIテキスト生成ベンチマークは、複数のLLM AIモデルでAIパフォーマンスを繰り返しかつ一貫してテストする、よりコンパクトで簡単な方法を提供します。当社は、AIのソフトウェアおよびハードウェアの多くのリーダーと緊密に連携して、当社のベンチマークテストがお客様のシステム内のローカルAIアクセラレータのハードウェアを最大限に活用できるようにします。

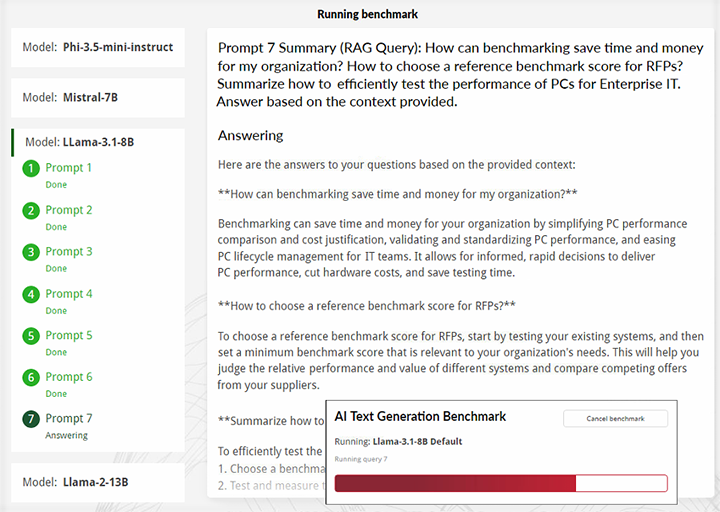

今すぐ購入プロンプト7(RAGクエリ):ベンチマークによって、組織の時間とコストはどのように削減できますか?RFPの参照用ベンチマークスコアは、どのように選択しますか?企業IT向けPCのパフォーマンスを効率的にテストする方法をまとめます。提供されている文脈に基づいて回答してください。

Procyonベンチマークは、業界、企業、報道機関向けに設計されており、プロフェッショナルユーザー向けに特別に作成されたテストと機能を備えています。ProcyonAIテキスト生成ベンチマークは、ULベンチマーク開発プログラム(BDP)で業界パートナーとともに設計・開発されました。BDPは、プログラムメンバーとの密接な連携により、適切かつ公平なベンチマークを作成することを目的としたUL Solutionsのイニシアチブです。

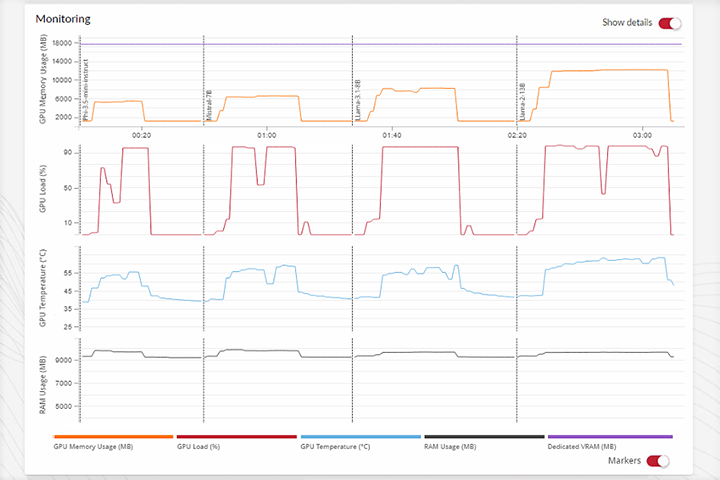

Procyon AIテキスト生成ベンチマークを使用すると、専用AI処理ハードウェアのパフォーマンスを測定し、負荷の高いAI画像生成ワークロードに基づくテストで推論エンジンの実装品質を検証できます。

当社は、推論エンジン実装と専用ハードウェアの一般的なAIパフォーマンスを評価する独立した標準化ツールを必要とするエンジニアリングチームに、Procyon AI推論ベンチマークを作成しました。

ベンチマークはインストールも実行も簡単で、複雑な設定は一切必要ありません。Procyonアプリケーションを使用、またはコマンドラインでベンチマークを実行します。ベンチマークスコアやチャートを表示、または詳細な結果ファイルをエクスポートしてさらに分析できます。

ストレージ:18.25GB

ストレージ:15.45GB

最新1.0.73.0 | 2024年12月9日