可解释机器学习技术1

需积分: 0 29 浏览量

更新于2022-08-04

收藏 725KB PDF 举报

可解释机器学习技术

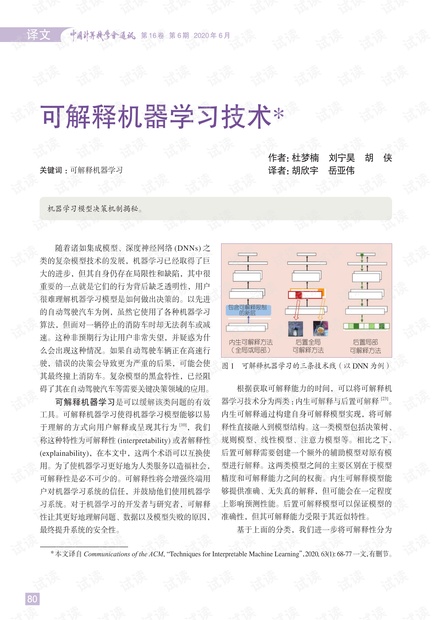

可解释机器学习是指机器学习模型能够以易于理解的方式向用户解释或呈现其行为的技术。可解释性是机器学习模型的重要特性,它能够增强终端用户对机器学习系统的信任,并鼓励他们使用机器学习系统。可解释机器学习技术可以分为内生可解释和后置可解释两类。内生可解释通过构建自身可解释模型实现,将可解释性直接融入到模型结构。后置可解释需要创建一个额外的辅助模型对原有模型进行解释。

内生可解释模型可以提供准确、无失真的解释,但可能会在一定程度上影响预测性能。后置可解释模型可以保证模型的准确性,但其可解释能力受限于其近似特性。可解释机器学习技术还可以分为机器学习模型决策机制揭秘、全局可解释性和局部可解释性三类。全局可解释性意味着用户可以通过考察复杂模型的结构和参数来理解模型的整体工作方式。而局部可解释性则针对模型的单个预测结果进行局部解释,试图找出模型做出决策的原因。

内生可解释模型可以通过设计自身可解释模型来实现,将可解释性直接融入到模型结构。构造的可解释模型既可以是全局可解释的,也可以为单个预测提供解释。全局可解释模型可以通过两种方式构建:直接使用数据训练,并添加可解释性约束;从复杂且不透明的模型中提取。添加可解释性约束可以提高模型的可解释性。一些典型的例子包括在分类模型中强制使用稀疏项或强制使用语义单调性约束。

此外,还可以在模型中添加更多语义约束,以进一步提高可解释性。例如,可解释卷积神经网络(CNN) 在较高卷积层中添加一个正则损失以学习得到非耦合特征表示,从而得到自然对象的语义检测滤波器。另外一个工作将称为胶囊的新型神经单元进行组合,构成胶囊网络。被激活的胶囊的响应向量表示各类语义概念,如特定物体的位置和姿态。这种特点使得胶囊网络更容易被人理解。

然而,当在模型中加入约束时,往往需要在预测精度和可解释性之间进行权衡。具有较好可解释性模型的预测精度可能要比具有较差可解释性模型的预测精度要低。可解释模型提取是一种替代方案,它不必过分牺牲模型的性能。模拟学习的目标是学习一个近似的模型,以便更好地理解和解释原有模型的行为。

可解释机器学习技术是机器学习领域的一个重要研究方向,它能够使机器学习模型更加透明、更加可靠、更加易于理解和使用。通过使用可解释机器学习技术,我们可以更好地理解机器学习模型的行为,并提高机器学习模型的性能和可靠性。

高工-老罗

- 粉丝: 27

- 资源: 314

最新资源

- 造价咨询薪酬管理办法.doc

- 中铁三局集团第二工程有限公司项目薪酬实施办法.doc

- 2025健康管理师三级专业能力考试题及答案.docx

- 2025健康素养知识竞赛题库(含答案).docx

- 2025交管12123驾驶证学法减分(学法免分)测试题及答案.docx

- 造价咨询公司绩效提成方案 (1).docx

- 造价咨询公司绩效提成方案.docx

- 工程造价咨询从业人员绩效考核制度.docx

- 造价咨询公司(咨询工作室)绩效提成方案-2018修订版 (1).docx

- 2025交管12123学法减分考试试题库及答案(通用版).docx

- 2025交管12123学法减分题库大全(附答案).docx

- 2025教师资格证结构化面试题库及答案.docx

- 2025教师招聘义务教育道德与法治课程方案(2022版)必考题库及答案.docx

- 2025教师资格证考试《教育知识与能力》知识点大全.docx

- 2025教育学公共基础知识考试题库及答案(通用版).docx

- 2025京东pop售前客服认证考试题及答案.docx