在Ubuntu 16.4操作系统下搭建Hadoop完全分布式环境是一项技术性较强的任务,涉及到多个步骤和配置。本文将详细讲解这一过程,帮助你成功构建一个高效稳定的Hadoop集群。

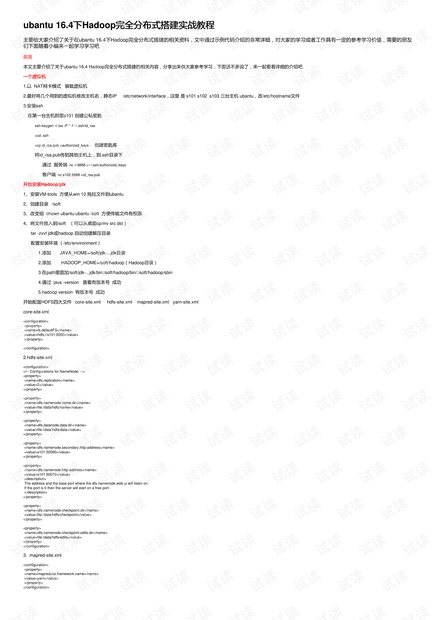

我们需要准备至少三台虚拟机,分别用作NameNode、DataNode和Secondary NameNode。这些虚拟机应设置为NAT网络模式,并且每个虚拟机都需要有自己的主机名和静态IP。例如,我们可以将主机名设为s101、s102和s103,并在`/etc/network/interfaces`文件中配置静态IP。同时,还需要修改`/etc/hostname`文件以匹配新的主机名。

接下来,确保所有虚拟机之间能进行SSH无密码登录。在第一台主机s101上生成SSH密钥对,使用命令`ssh-keygen -t rsa -P '' -f ~/.ssh/id_rsa`。然后,将`id_rsa.pub`文件复制到其他主机的`.ssh/authorized_keys`文件中,可以使用`nc`命令实现文件传输,如`nc -l 8888 >~/.ssh/authorized_keys`在服务端接收,`nc s102 8888 <id_rsa.pub`在客户端发送。

安装必要的软件是关键步骤之一。首先安装VMware Tools,以便于在Windows和Ubuntu之间拖放文件。然后,创建一个名为`/soft`的目录,用于存放安装文件。通过修改文件所有权`chown ubantu:ubantu /soft`,确保用户ubantu有权限写入该目录。接下来,将Java JDK和Hadoop的tar.gz文件复制到`/soft`目录并解压。配置环境变量,包括在`/etc/environment`文件中添加`JAVA_HOME`、`HADOOP_HOME`,以及相应的`PATH`,并验证安装是否成功,使用`java -version`和`hadoop version`命令。

配置Hadoop的HDFS四大核心文件:`core-site.xml`、`hdfs-site.xml`、`mapred-site.xml`和`yarn-site.xml`。在`core-site.xml`中,设置默认文件系统为`fs.defaultFS`,如`hdfs://s101:9000`。在`hdfs-site.xml`中,配置NameNode的副本数`dfs.replication`,以及NameNode和DataNode的数据存储路径,如`dfs.namenode.name.dir`和`dfs.datanode.data.dir`。还要设置Secondary NameNode的HTTP地址和NameNode的HTTP地址。

对于`mapred-site.xml`,你需要指定MapReduce框架的相关配置,通常会设置YARN作为作业管理系统,如`mapreduce.framework.name`为`yarn`。在`yarn-site.xml`中,配置YARN的内存和CPU资源分配策略以及其他相关属性。

在所有机器上完成这些配置后,启动Hadoop服务。首先格式化NameNode,然后启动各个服务组件,如`hadoop-daemon.sh start namenode`、`hadoop-daemon.sh start datanode`等。检查Hadoop集群的状态,通过访问NameNode的Web UI(默认在50070端口)确认DataNode是否已经注册并且集群运行正常。

此外,为了提高数据安全性,还可以配置Hadoop的权限管理,例如启用HDFS的Access Control List (ACL) 和Hadoop的Kerberos认证。同时,监控系统的性能和日志,定期进行健康检查,确保数据的完整性和集群的稳定性。

搭建Hadoop完全分布式环境涉及网络配置、软件安装、环境变量设置、配置文件修改以及服务启动等多个环节。每个步骤都需要细心操作,以确保集群的稳定运行。通过实践这个教程,你不仅可以提升自己的Linux和Hadoop技能,还能更好地理解大数据处理的基础架构。