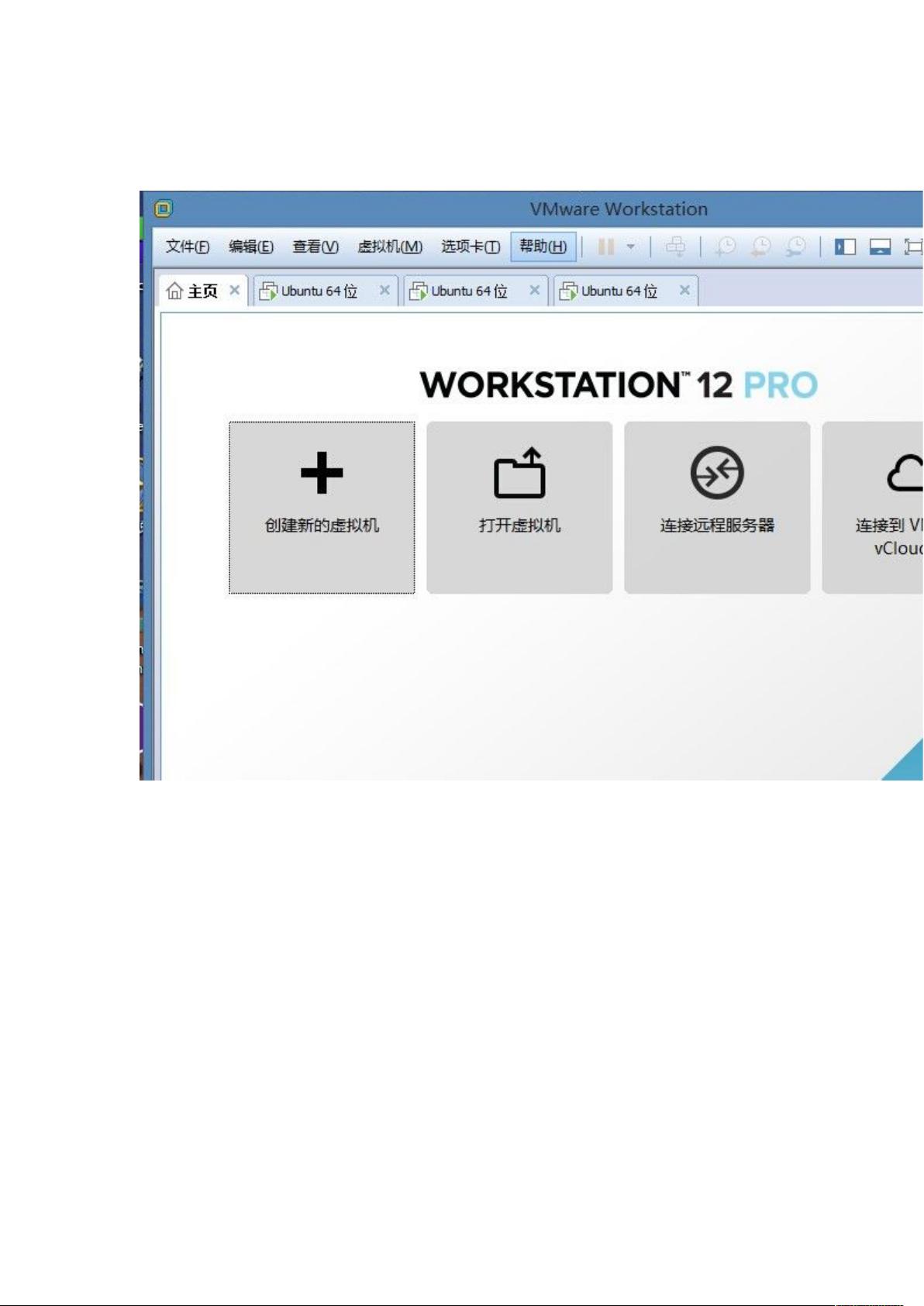

### 从零开始搭建Hadoop2 分布式集群 #### 概述 本文档旨在详细介绍如何从零开始搭建Hadoop2.7.1的分布式集群。Hadoop是一种能够处理大量数据的大规模分布式存储与处理框架,它通过提供高可靠性、高性能、可扩展性的计算平台,使得大数据处理变得更加简单高效。本指南将涵盖从安装必要的软件环境到配置Hadoop的所有步骤,并针对常见的配置问题给出了解决方案。 #### 操作环境说明 - **操作系统**:Windows 8.1 (用于搭建虚拟机) - **虚拟机版本**:VMware 12 #### 材料准备 - **Ubuntu光盘映像**:`ubuntu-14.10-desktop-amd64.iso` - **Java环境包**:`jdk-8u65-linux-x64.gz` - **Hadoop环境包**:`hadoop-2.7.1.tar.gz` #### 搭建开始 ##### 创建虚拟机 根据Hadoop的调度规则,使用VMware 12加载`ubuntu-14.10-desktop-amd64.iso`创建三个Ubuntu虚拟机。这些虚拟机将分别作为Master节点和两个Slave节点: - **虚拟机1**:MasterUbuntu14.10 64bit - **虚拟机2**:Slave1Ubuntu14.10 64bit - **虚拟机3**:Slave2Ubuntu14.10 64bit #### 配置步骤详解 ##### 解压文件 - 将`jdk-8u65-linux-x64.gz`和`hadoop-2.7.1.tar.gz`拷贝到每台虚拟机中的`Home/Download`文件夹中。 - 右键选择`Extract Here`解压文件,或使用命令行方式解压: ```bash tar -zxvf jdk-8u65-linux-x64.gz tar -zxvf hadoop-2.7.1.tar.gz ``` ##### 配置Java环境 1. **创建目录**: ```bash sudo mkdir /usr/lib/jvm ``` 2. **复制Java环境包**: ```bash sudo cp -r Downloads/jdk1.8.0_65 /usr/lib/jvm/ ``` 3. **添加环境变量**: ```bash sudo gedit /etc/profile ``` 在文件末尾添加以下四行: ```bash export JAVA_HOME=/usr/lib/jvm/jdk1.8.0_65 export JRE_HOME=${JAVA_HOME}/jre export CLASSPATH=.:${JAVA_HOME}/lib:${JRE_HOME}/lib export PATH=${JAVA_HOME}/bin:$PATH ``` 4. **使环境变量生效**: ```bash source /etc/profile ``` 5. **验证Java环境**: ```bash java -version ``` ##### 安装与配置SSH 1. **更新APT源**: ```bash sudo apt-get update ``` 2. **安装SSH服务**: ```bash sudo apt-get install openssh-server ``` 3. **验证SSH服务**: ```bash ps -e | grep ssh ``` 4. **解决安装问题**:如果遇到404 Not Found错误,可以尝试下载`sources.list`文件并替换原有的APT源文件: ```bash sudo cp sources.list /etc/apt/sources.list sudo apt-get update sudo apt-get install openssh-server ``` 5. **验证SSH安装**: ```bash ssh localhost ``` 6. **生成SSH密钥对**: ```bash ssh-keygen -t rsa ``` 7. **复制公钥**:在Master主机中复制一份公钥到home中: ```bash cp ~/.ssh/id_rsa.pub ~/id_rsa_master.pub ``` 8. **分发公钥**:将Master主机中的`id_rsa_master.pub`文件拷贝到Slave1和Slave2的home目录下,并将其添加到`.ssh/authorized_keys`文件中: ```bash cat id_rsa_master.pub >> .ssh/authorized_keys ``` 9. **实现无密码登录**:至此,Master节点可以实现对Slave1和Slave2的无密码登录。 ##### 配置Hadoop 1. **创建临时目录**:在Hadoop目录下创建临时目录: ```bash mkdir hadoop-2.7.1/tmp ``` 2. **配置Hadoop的核心配置文件**:编辑`hadoop-2.7.1/etc/hadoop/core-site.xml`和`hadoop-2.7.1/etc/hadoop/hdfs-site.xml`,确保指定了正确的NameNode和DataNode的位置以及其他必要参数。 3. **格式化NameNode**:在Master节点上运行命令: ```bash hdfs namenode -format ``` 4. **启动Hadoop集群**:使用以下命令启动Hadoop服务: ```bash start-dfs.sh start-yarn.sh ``` 5. **验证Hadoop服务**:检查Hadoop服务状态: ```bash jps ``` 应该能看到`NameNode`, `DataNode`, `NodeManager`, `ResourceManager`等进程。 #### 总结 通过上述步骤,您可以从零开始搭建一个Hadoop2.7.1的分布式集群。此过程涉及到了环境配置、Java环境设置、SSH无密码登录配置以及Hadoop的基本配置与启动。通过实践这一过程,不仅可以掌握Hadoop的基础架构,还能深入理解大数据处理的关键技术之一——分布式文件系统HDFS和MapReduce的工作原理。

剩余25页未读,继续阅读

- 粉丝: 0

- 资源: 6

我的内容管理

展开

我的内容管理

展开

我的资源

快来上传第一个资源

我的资源

快来上传第一个资源

我的收益 登录查看自己的收益

我的收益 登录查看自己的收益 我的积分

登录查看自己的积分

我的积分

登录查看自己的积分

我的C币

登录后查看C币余额

我的C币

登录后查看C币余额

我的收藏

我的收藏  我的下载

我的下载  下载帮助

下载帮助

前往需求广场,查看用户热搜

前往需求广场,查看用户热搜最新资源

- chromedriver-win64_134.0.6944.2.zip

- chromedriver-win64_134.0.6944.0.zip

- chromedriver-win64_133.0.6943.6.zip

- chromedriver-win64_134.0.6945.2.zip

- chromedriver-win64_134.0.6945.0.zip

- chromedriver-win64_134.0.6946.0.zip

- SpringBoot天气预报小程序

- chromedriver-win64_134.0.6947.0.zip

- chromedriver-win64_134.0.6949.0.zip

- chromedriver-win64_134.0.6948.0.zip

- chromedriver-win64_134.0.6952.0.zip

- chromedriver-win64_134.0.6953.0.zip

- chromedriver-win64_134.0.6950.0.zip

- chromedriver-win64_134.0.6954.0.zip

- chromedriver-win64_134.0.6956.0.zip

- chromedriver-win64_134.0.6955.0.zip

信息提交成功

信息提交成功