Panoramica

Una piattaforma di intelligenza artificiale (IA) è una raccolta integrata di tecnologie utili per sviluppare, addestrare ed eseguire i modelli di apprendimento automatico. In genere include funzionalità di automazione, operazioni di machine learning (MLOps), analisi predittiva dei dati e molto altro. Questa piattaforma offre una base robusta per le tue attività di creazione e messa a punto dei modelli, centralizzando in un'unica ubicazione tutti gli strumenti necessari allo svolgimento di tali operazioni.

Attualmente è possibile scegliere tra svariate tipologie di piattaforme di IA, ognuna con fasi iniziali di adozione specifiche. Di seguito elenchiamo le considerazioni più importanti da tenere a mente per scegliere la piattaforma più adatta.

Tipologie di piattaforme di IA

Il primo passo da compiere è decidere se acquistare una piattaforma di IA preconfigurata o realizzarne una personalizzata per l'organizzazione.

Acquisto di una piattaforma di IA

Se la priorità è il deployment rapido di algoritmi, modelli e applicazioni di IA, la scelta migliore è acquistare una piattaforma di IA completa e preconfigurata, che includa strumenti, repository di linguaggi e API testati in anticipo dal punto di vista della sicurezza e delle prestazioni. Alcuni fornitori offrono una base pre-addestrata e modelli di IA generativa. Grazie all'assistenza e alle risorse di onboarding, diventa facile integrarli negli ambienti e nei flussi di lavoro esistenti.

I provider di cloud più diffusi hanno iniziato a includere nella propria offerta svariate piattaforme di IA, come Amazon Web Services (AWS) Sagemaker, Google Cloud AI Platform, Microsoft Azure AI Platform e watsonx.ai™ AI studio di IBM. In molti casi, i provider di piattaforme di IA offrono anche strumenti di IA standalone che possono essere utilizzati unitamente ad altre soluzioni basate sulla stessa tecnologia.

Realizzazione di una piattaforma di IA

Per soddisfare particolari scenari di utilizzo o esigenze di privacy, alcune organizzazioni hanno bisogno di una piattaforma di IA completamente personalizzata da gestire in autonomia. Per esempio, Uber ha sviluppato una piattaforma di IA personalizzata che utilizza tecnologie come l'elaborazione del linguaggio naturale e la visione artificiale per migliorare il GPS e le funzionalità di rilevamento degli incidenti. Syapse, un'azienda sanitaria che si occupa dell'elaborazione dei dati, ha realizzato Syapse Raydar®, una piattaforma basata sull'IA che trasforma i dati oncologici in informazioni fruibili.

La creazione di una propria piattaforma di IA consente di avere il controllo totale sull'ambiente e di fare iterazioni a seconda delle esigenze specifiche dell'azienda. Tuttavia, questo approccio richiede una preparazione maggiore prima di poter iniziare a utilizzare la piattaforma. Inoltre, la manutenzione, il supporto e la gestione non possono essere esternalizzati.

I vantaggi dell'open source

Le comunità open source stanno compiendo notevoli progressi nell'ambito dell'intelligenza artificiale e del machine learning. Scegliere un software open source come base delle attività basate sull'IA significa poter fare affidamento su una community di esperti, costantemente impegnati a migliorare gli strumenti e i framework più comunemente adottati. Molte organizzazioni scelgono di realizzare le proprie soluzioni partendo dagli strumenti open source. Tensorflow e PyTorch sono piattaforme open source che offrono librerie e framework per lo sviluppo delle applicazioni di IA.

Risorse da Red Hat

Funzionalità importanti in una piattaforma di IA

MLOps

Con MLOps (Machine Learning Operations per esteso) si intende un insieme di metodologie per i flussi di lavoro progettato per semplificare il processo di distribuzione e gestione dei modelli di machine learning (ML). Una piattaforma di IA deve essere in grado di supportare le varie fasi del metodo MLOps, come addestramento, fornitura e monitoraggio dei modelli.

Il termine LLMOps (Large Language Model Operations) si riferisce a un sottoinsieme di MLOps che include pratiche, tecniche e strumenti per la gestione operativa dei modelli linguistici di grandi dimensioni in ambienti di produzione. Gli LLM sono in grado di svolgere varie attività, come creazione di testi, sintesi di contenuti e classificazione di informazioni, ma richiedono ingenti quantità di risorse di elaborazione dai GPU. Ciò significa che la piattaforma di IA deve essere abbastanza efficiente da supportare gli input e gli output degli LLM.

IA generativa

L'intelligenza artificiale generativa crea nuovi contenuti sfruttando reti neurali e modelli di deep learning addestrati con grandi insiemi di dati. Con il giusto addestramento, il modello è in grado di applicare le informazioni ricevute a situazioni reali, in un processo chiamato inferenza.

L'IA generativa comprende molte funzioni che gli utenti finali associano con l'intelligenza artificiale in generale, come la generazione di testi e immagini, la data augmentation, i sistemi di IA per le conversazioni (come le chatbot) e molto altro. È importante che la piattaforma di IA sia in grado di supportare le funzionalità dell'intelligenza artificiale generativa in modo rapido e accurato.

Scalabilità

I modelli possono essere realmente efficaci solo se sono scalabili. Per realizzare modelli di questo tipo, i data scientist hanno bisogno di una soluzione centralizzata che consenta di creare e distribuire modelli di IA, affinare i processi e collaborare con altri team. Tutto ciò richiede enormi quantità di dati, un'elevata potenza di elaborazione e, soprattutto, una piattaforma adeguata.

Inoltre, dopo aver realizzato dei modelli efficaci, occorre poterli riprodurre on premise, sulle piattaforme di cloud pubblico o all'edge. Scegliendo una soluzione scalabile sarai in grado di supportare il deployment in qualsiasi tipologia di ambiente.

Automazione

Quando i modelli pronti per essere immessi in produzione iniziano a superare la decina, implementare l'automazione diventa necessario. L'automazione delle pipeline di data science ti permette di trasformare i tuoi processi più efficienti in operazioni ripetibili. In questo modo puoi accelerare i flussi di lavoro, ottimizzare la scalabilità e migliorare le esperienze offerte agli utenti, rendendole più prevedibili. Di conseguenza, le attività ripetitive vengono eliminate e i data scientist e gli ingegneri possono dedicare più tempo all'innovazione, alle iterazioni e al perfezionamento dei modelli.

Strumenti e integrazioni

Gli sviluppatori e i data scientist utilizzano strumenti e integrazioni per creare modelli e applicazioni ed eseguirne il deployment in modo efficiente. La piattaforma di IA deve supportare gli strumenti, i linguaggi e i repository già utilizzati dai tuoi team e integrare al tempo stesso le soluzioni dei partner e l'intero stack tecnologico.

Sicurezza e regolamentazione

L'impostazione di procedure di sicurezza solide nella tua piattaforma di IA ti permette di ridurre i rischi e proteggere i dati. Durante le operazioni quotidiane di addestramento e sviluppo è fondamentale rintracciare le CVE (Common Vulnerabilities and Exposures) e adottare misure di protezione per i dati e le applicazioni, come gestione degli accessi, segmentazione della rete e crittografia.

Responsabilità e governance

La piattaforma di IA deve anche consentirti di utilizzare e monitorare i dati nel rispetto degli standard etici e della conformità. Per proteggere sia i dati dell'organizzazione che quelli degli utenti, è essenziale scegliere una piattaforma che supporti visibilità, tracciamento e strategie di gestione del rischio nell'intero ciclo di vita del machine learning. Inoltre, la piattaforma deve anche soddisfare gli standard dell'organizzazione in materia di sicurezza e conformità ai requisiti normativi dei dati.

Supporto

Uno dei principali vantaggi di una piattaforma di IA end to end preconfigurata è che include un servizio di supporto. Il tracciamento continuo dei bug e le correzioni scalabili applicate ai deployment migliorano le prestazioni dei modelli. Alcuni provider di piattaforme di IA offrono risorse per la formazione e l'onboarding che permettono ai team di diventare subito operativi. Scegliere provider che garantiscano un servizio di supporto per l'infrastruttura e le funzionalità del machine learning è un'opzione altamente consigliata alle organizzazioni che preferiscono creare una propria piattaforma con strumenti open source.

Scenari di utilizzo delle piattaforme di IA

Telecomunicazioni

I servizi completi di AI/ML possono essere utilizzati nel settore delle telecomunicazioni per svolgere diversi compiti, come ottimizzare le prestazioni della rete e migliorare la qualità dei prodotti e dei servizi. Le applicazioni includono una qualità del servizio migliorata, potenziamenti audiovisivi e la prevenzione della perdita di clienti.

Sanità

Una piattaforma di IA robusta può offrire cambiamenti radicalmente vantaggiosi nell'ambito sanitario, come diagnosi più rapide, progressi nella ricerca clinica e un migliore accesso ai servizi per i pazienti. Questi benefici hanno un impatto significativo sulla cura dei pazienti perché permettono al personale medico di diagnosticare le malattie e fornire un piano terapeutico in maniera più accurata.

Settore manifatturiero

L'automazione intelligente basata sul machine learning sta rivoluzionando il settore manifatturiero nell'intera catena di distribuzione. La robotica industriale e l'analisi predittiva stanno riducendo le attività ripetitive e consentono l'implementazione di flussi di lavoro più efficaci in tempo reale.

Il ruolo di Red Hat

Quando si sceglie una piattaforma di IA, bisogna dare priorità a soluzioni flessibili e affidabili su larga scala.

Red Hat® AI offre un portafoglio di prodotti di IA sviluppati a partire dalle soluzioni che i nostri clienti già conoscono.

Grazie alle soluzioni per l'IA di Red Hat, le organizzazioni possono:

- Adottare l'IA rapidamente per promuovere l'innovazione.

- Semplificare l'erogazione di soluzioni di IA.

- Eseguire il deployment in tutti gli ambienti.

Unisci scalabilità e flessibilità

Se vuoi iniziare a utilizzare l'IA su larga scala, la piattaforma di Red Hat per l'IA offre agli sviluppatori gli strumenti per creare, distribuire e gestire le applicazioni basate su questa tecnologia.

Le soluzioni per l'IA di Red Hat offrono anche meccanismi di allineamento dei modelli per migliorare gli LLM grazie a InstructLab, e sono caratterizzate da un approccio open source orientato alla community per il miglioramento delle funzionalità degli LLM.

Grazie alla collaborazione continua e supportata, puoi personalizzare le applicazioni dei modelli di IA per i tuoi scenari di utilizzo aziendali in modo semplice e rapido.

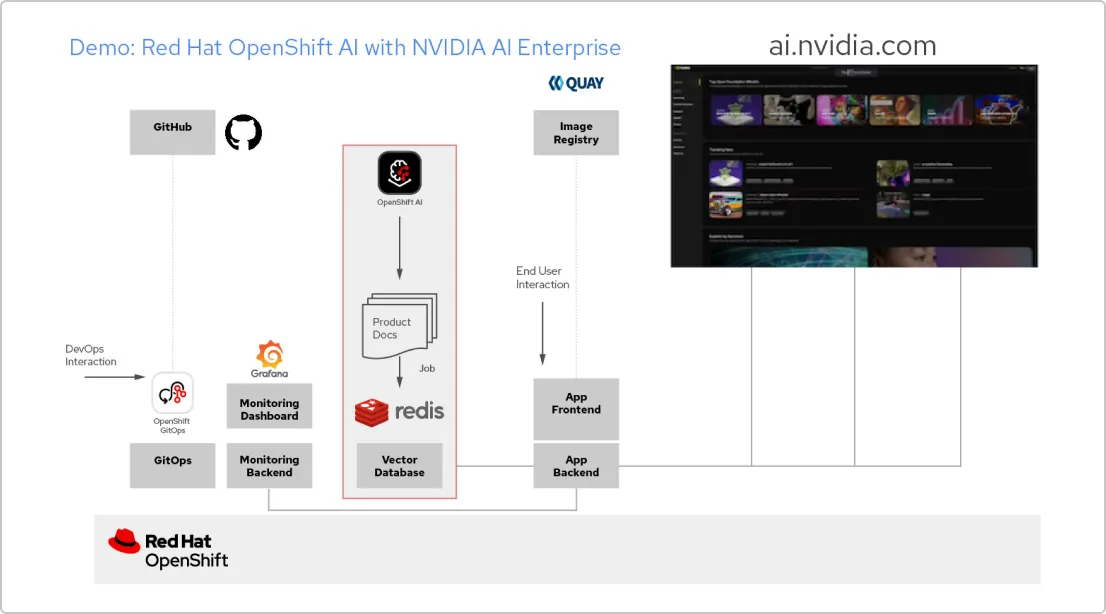

Analisi della soluzione: app di IA con Red Hat e NVIDIA AI Enterprise

Crea un'applicazione RAG

Red Hat OpenShift AI è una piattaforma per creare progetti di data science e distribuire applicazioni abilitate all'IA. Puoi integrare tutti gli strumenti che ti servono per supportarela tecnologia retrieval augmented generation (RAG), un metodo per ottenere le risposte dell'IA dai tuoi documenti di riferimento. Quando connetti OpenShift AI con NVIDIA AI Enterprise, puoi fare alcune prove con gli LLM (Large Language Model) per trovare il modello ideale per la tua applicazione.

Sviluppa una pipeline per i documenti

Se vuoi usare la tecnologia RAG, per prima cosa devi inserire i tuoi documenti in un database vettoriale. Nella nostra app di esempio, integriamo una serie di documenti di prodotto in un database Redis. Visto che questi documenti vengono modificati spesso, possiamo creare una pipeline da eseguire periodicamente per tale processo in modo da disporre sempre della versione più recente.

Sfoglia il catalogo degli LLM

NVIDIA AI Enterprise ti offre l'accesso a un catalogo di diversi modelli LLM, così potrai fare diverse prove e scegliere quello che offre risultati migliori. I modelli sono ospitati nel catalogo delle API di NVIDIA. Una volta che hai impostato un token API, puoi eseguire il deployment di un modello utilizzando la piattaforma di distribuzione dei modelli NVIDIA NIM direttamente da OpenShift AI.

Scegli il modello giusto

Mentre fai alcune prove con i diversi modelli LLM, i tuoi utenti possono valutare ogni risposta generata. Puoi configurare una dashboard di monitoraggio Grafana per confrontare le valutazioni, oltre che i tempi di risposta e di latenza di ogni modello. Potrai quindi sfruttare questi dati per scegliere il miglior modello LLM da usare nel tuo ambiente di produzione.

Il blog ufficiale di Red Hat

Leggi gli articoli del blog di Red Hat per scoprire novità e consigli utili sulle nostre tecnologie, e avere aggiornamenti sul nostro ecosistema di clienti, partner e community.