概要

人工知能 (AI) プラットフォームとは、機械学習モデルを開発、訓練、実行するための統合されたテクノロジーの集合体です。AI プラットフォームには通常、自動化機能、機械学習運用 (MLOps)、予測データ分析などが含まれます。作業に必要なすべてのツールが揃い、構築および改良を行うための安定した基盤が提供される作業台のようなものだと考えたら良いでしょう。

AI プラットフォームとその開始方法の選択肢は増え続けています。ここでは注目すべき点のほか、留意すべき最重要事項をご紹介します。

AI プラットフォームの種類

AI プラットフォームにおいて組織が初めに直面するのは、事前構成済みのものを購入するか、自社でカスタムプラットフォームを構築するかという決断です。

AI プラットフォームを購入する

AI アプリケーション、モデル、アルゴリズムの迅速なデプロイを検討している場合、包括的な事前構成済み AI プラットフォームの購入が最適です。これらのプラットフォームには、ツール、言語リポジトリ、API が付属しており、セキュリティとパフォーマンスが事前にテストされています。一部のベンダーは、事前にトレーニングされた基礎モデルや生成 AI モデルを提供しています。サポートとオンボーディングリソースにより、既存の環境やワークフローにスムーズに適合させることができます。

Amazon Web Services (AWS) Sagemaker、Google Cloud AI Platform、Microsoft Azure AI Platform、IBM の watsonx.ai™ AI スタジオなど、人気のクラウドプロバイダーは AI プラットフォームでポートフォリオを拡大しています。多くの場合、AI プラットフォーム・プロバイダーは他の AI ソリューションと提携および統合可能なスタンドアローンの AI ツールも提供しています。

AI プラットフォームを構築する

特定のユースケースや高度なプライバシー保護のニーズに対応するため、組織によっては独自の AI プラットフォームを完全にカスタマイズし、管理する必要があります。たとえば Uber は、自然言語処理 (NLP) やコンピュータビジョンなどの技術を駆使したカスタム AI プラットフォームを開発し、GPS と衝突検知能力を向上させました。データ重視のヘルスケア企業である Syapse は、腫瘍に関するデータを実用的な知見に変換する AI ベースのデータプラットフォーム Syapse Raydar® を開発しました。

AI プラットフォームを構築することで環境を完全にコントロールすることができ、ビジネス特有のニーズに合わせて反復させることができます。しかしこのアプローチでは、プラットフォームを立ち上げて稼働させるために、より多くの先行作業が必要となります。メンテナンス、サポート、管理を外注することはできません。

オープンソースを活用する

オープンソース・コミュニティは、人工知能と機械学習の進歩を推進しています。AI イニシアチブの基盤としてオープンソース・ソフトウェア・ソリューションを選択すると、組織が最も使用するフレームワークやツールを常に改善している仲間や実務者のコミュニティに頼ることができます。多くの組織はオープンソースツールから始め、そこから構築していきます。Tensorflow と PyTorch は、AI アプリケーションを開発するためのライブラリとフレームワークを提供するオープンソース・プラットフォームです。

Red Hat のリソース

AI プラットフォームで注目すべき機能

MLOps

機械学習運用 (MLOps) とは、ML モデルのデプロイと保守のプロセスを最適化することを目的としたワークフローの一連のプラクティスです。AI プラットフォームは、モデルのトレーニング、サービス提供、監視といった MLOps フェーズをサポートする必要があります。

大規模言語モデル運用 (LLMOps) は MLOps のサブセットであり、本番環境で大規模言語モデルの運用管理に使用されるプラクティス、技術、ツールです。LLM はテキストの生成、コンテンツの要約、情報の分類などのタスクを実行できるものの、GPU から多大な計算リソースを消費するため、使用する AI プラットフォームは LLM の入出力に対応してサポートするのに十分強力である必要があります。

生成 AI

生成 AI は大規模なデータセットで訓練されたニューラルネットワークとディープラーニングモデルを使用して新しいコンテンツを作成します。十分なトレーニングを行うことで、モデルはトレーニングで学習したことを応用し、それを実際の状況に当てはめることができます。これを AI 推論と呼びます。

生成 AI は、テキストや画像の生成、データの拡張、チャットボットなどの会話型 AI など、エンドユーザーが人工知能から連想するような機能の多くを含みます。AI プラットフォームでは、生成 AI 機能を迅速かつ正確にサポートすることが重要になります。

スケーラビリティ

モデルは規模をスケーリングできてこそ成功します。スケーリングさせるため、データサイエンスチームには AI モデルの構築とデプロイ、実験と微調整、他のチームとの連携を行うための一元化されたソリューションが必要です。これらすべてには、膨大な量のデータとコンピューティングパワーのほか、それらすべてを処理できるプラットフォームが必要です。

モデルが成功すると、それをさまざまな環境 (オンプレミス、パブリッククラウド・プラットフォーム、エッジ) で再現したいと考えるでしょう。スケーラブルなソリューションであれば、これらすべての環境でのデプロイをサポートすることができます。

自動化

本番環境へと進めたいモデルが増加するにつれ、自動化を検討しなければならなくなります。データサイエンス・パイプラインを自動化することで、最も成功したプロセスを反復可能な運用に変えることができます。これによりワークフローが高速化されるだけでなく、ユーザーにとってより優れた予測可能なエクスペリエンスが実現し、スケーラビリティが向上します。また、繰り返しのタスクを排除し、データサイエンティストやエンジニアが革新、反復、改良を行うための時間を確保することができます。

ツールと統合

開発者やデータサイエンティストは、アプリケーションやモデルを構築し、それらを効率的にデプロイするためにさまざまなツールや統合を活用しています。AI プラットフォームは、技術スタック全体やパートナーのソリューションと統合でき、チームがすでに使用しているツール、言語、リポジトリをサポートできる必要があります。

セキュリティと規制

AI プラットフォームとともに強力なセキュリティ対策を確立することで、リスクを軽減し、データを保護できます。トレーニングや開発などの日常の運用を通じて、共通脆弱性識別子 (CVE) をスキャンし、アクセス管理、ネットワーク・セグメンテーション、暗号化を通じてアプリケーションやデータの運用上の保護を確立することが重要です。

責任とガバナンス

また、AI プラットフォームは、倫理基準を守り、コンプライアンス違反を回避しながら、データを使用および監視できるようになっていなければなりません。組織のデータとユーザーデータの両方を保護するためには、ML ライフサイクル全体を通じて可視化、追跡、リスク管理戦略をサポートするプラットフォームを選択することが重要です。また、組織の既存のデータコンプライアンスとセキュリティの基準を満たしている必要があります。

サポート

エンドツーエンドの事前構成済み AI プラットフォームの最も重要な利点の 1 つは、それに付随するサポートです。継続的なバグ追跡とデプロイメント全体に拡張できる修復機能により、モデルのパフォーマンスが向上します。AI プラットフォーム・プロバイダーの中には、オンボーディングやトレーニングリソースを提供し、すぐに使い始められるものもあります。オープンソースツールを使用して独自のプラットフォームを構築する場合、機械学習機能セットとインフラストラクチャのサポートを提供するベンダーの利用を検討することをお勧めします。

AI プラットフォームのユースケース

通信

包括的な AI サービスは、ネットワークのパフォーマンス最適化や通信の製品およびサービスの品質強化など、通信業界のさまざまな部分を効率化することができます。 サービス品質の向上、オーディオ/ビジュアルの強化、解約の防止などに活用できます。

医療

堅牢な AI プラットフォームは、診断の迅速化、臨床研究の進歩、患者サービスへのアクセス拡大など、医療環境に変革をもたらすことができます。これにより医師やその他の医療従事者がより正確な診断と治療計画を提供できるようになり、患者の転帰を向上させることができます。

製造

機械学習を活用したインテリジェントな自動化は、製造業のサプライチェーン全体を変革しています。産業用ロボティクスと予測分析が繰り返しタスクの負担を軽減し、より効果的なワークフローがリアルタイムで実装されます。

Red Hat のサポート内容

AI プラットフォームに関して、Red Hat は柔軟で信頼できる AI ソリューションを大規模に構築することを優先します。

Red Hat® AI は、Red Hat のお客様の信頼を得ているソリューションに基づいて構築された AI 製品のポートフォリオです。

Red Hat AI のサポートによって以下のことが可能になります。

- AI を迅速に導入してイノベーションを実現する

- AI ソリューションの提供における複雑さを解消できる

- どこにでもデプロイできる

柔軟に拡張

拡張する準備ができているお客様には、Red Hat AI プラットフォームが開発者に AI 対応アプリケーションを構築、デプロイ、管理するためのツールを提供します。

Red Hat AI は、InstructLab というソリューションによって、LLM を改善するための追加のモデルアライメント・メカニズムも提供します。LLM の機能を拡張するための、オープンソース・コミュニティが主導するアプローチを導入します。

サポート付きの継続的なコラボレーションにより、エンタープライズ・ユースケースに合わせてすばやく簡単に AI モデルアプリケーションをカスタマイズできます。

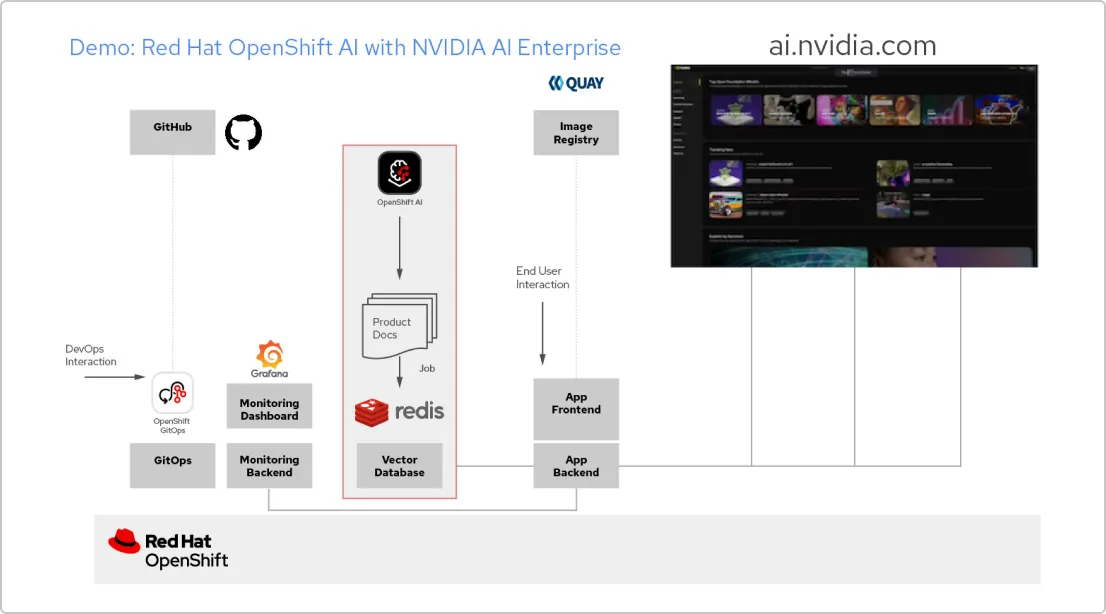

ソリューションパターン:Red Hat と NVIDIA AI Enterprise による AI アプリケーション

RAG アプリケーションを作成する

Red Hat OpenShift AI は、データサイエンス・プロジェクトを構築し、AI 対応アプリケーションを提供するためのプラットフォームです。独自の参照ドキュメントから AI の回答を取得する手法の 1 つである検索拡張生成 (RAG) をサポートするために必要なすべてのツールを統合できます。OpenShift AI を NVIDIA AI Enterprise に接続すると、大規模言語モデル (LLM) を試して、アプリケーションに最適なモデルを見つけることができます。

ドキュメントのパイプラインを構築する

RAG を利用するには、まずドキュメントをベクトルデータベースに取り込む必要があります。サンプルアプリでは、一連の製品ドキュメントを Redis データベースに埋め込んでいます。これらのドキュメントは頻繁に変更されるため、定期的に実行するこのプロセス用のパイプラインを作成すると、常に最新バージョンのドキュメントを入手できます。

LLM カタログを閲覧する

NVIDIA AI Enterprise ではさまざまな LLM のカタログにアクセスできるため、さまざまな選択肢を試して、最良の結果が得られるモデルを選択できます。モデルは NVIDIA API カタログでホストされています。API トークンを設定したら、OpenShift AI から直接 NVIDIA NIM モデル提供プラットフォームを使用してモデルをデプロイできます。

適切なモデルを選択する

さまざまな LLM をテストする際、ユーザーは生成される応答をそれぞれ評価することができます。Grafana モニタリング・ダッシュボードを設定して、各モデルの評価だけでなく、レイテンシーと応答時間も比較できます。そのデータを使用して、プロダクションで使用する最適な LLM を選択できます。

Red Hat 公式ブログ

Red Hat のお客様、パートナー、およびコミュニティのエコシステムに関する最新の情報を入手しましょう。